Dieser Artikel basiert auf meinem Vortrag bei der 5. Internationale Jahrestagung CURPAS für Autonome Systeme im Zentrum für Luft- und Raumfahrt (ZLR) in Wildau.

Wir bevölkern unsere Welt mit komplexen Maschinen und kommunizieren mit ihnen. In Zukunft werden uns immer neue autonome und komplexe Maschinen umgeben – der Kontakt zu den Maschinen nimmt zu.

Wie interagieren wir mit der Machine-Sphäre?

Viele autonome Systeme, z.B der Bus, der ohne Fahrer durch Tegel fährt oder die Pizzalieferdrohne, haben aktuell noch eine menschliche Betreuungsperson dabei, die eingreift, wenn etwas schief geht. Diese Person kann antworten, wenn Fahrgäste Fragen stellen.

Für den Moment und für den Proof of Concept ist so eine Begleitung prima. Langfristig muss das Gerät allerdings in der Lage sein, sich selbst zu erklären. Wir können keine komplexen Geräte herumfahren lassen, wenn sie nicht mit der Umwelt interagieren können.

Wie kann so ein User-Interface aussehen?

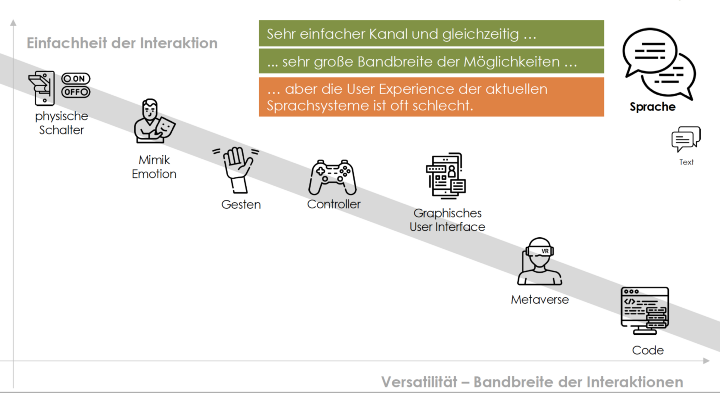

Wenn wir uns die wichtigsten Kontaktpunkte mit Maschinen ansehen, sehen wir, dass mit der Bandbreite der Interaktion die Einfachheit der Steuerungsmethoden zurückgeht und die Kommunikation schwieriger wird: Mit einem Schalter kann ich ein Gerät an- und ausschalten – sehr viel mehr aber nicht. Ich kann keine komplexen Handlungen triggern.

Einen Sweet-Spot sehen wir dagegen bei der Nutzung von Sprache: Damit lassen sich viele Interaktionen auslösen. Gleichzeitig ist diese Art der Kommunikation für die meisten Menschen einfach und natürlich anzuwenden.

Warum hat sich Sprachsteuerung bislang also noch nicht so richtig durchgesetzt?

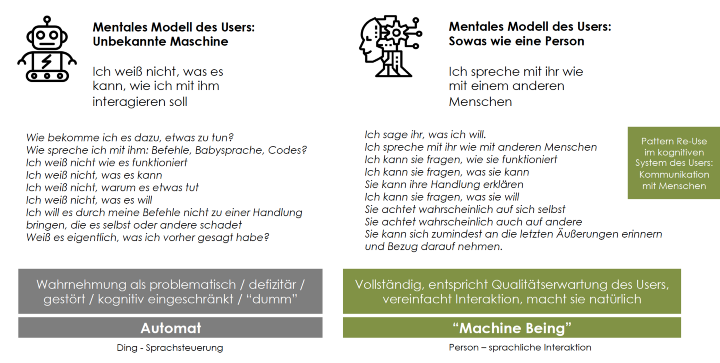

Viele Sprachinterfaces sind qualitativ nicht gut genug und haben eine schreckliche User Experience. Die Maschinen tun sich immer noch schwer, die Wünsche der Nutzer zu erkennen. Ich weiß nicht, was das Ding kann und muss es meist über die harte Tour lernen: ich bekomme frustrierend oft gesagt, dass es mich nicht versteht.

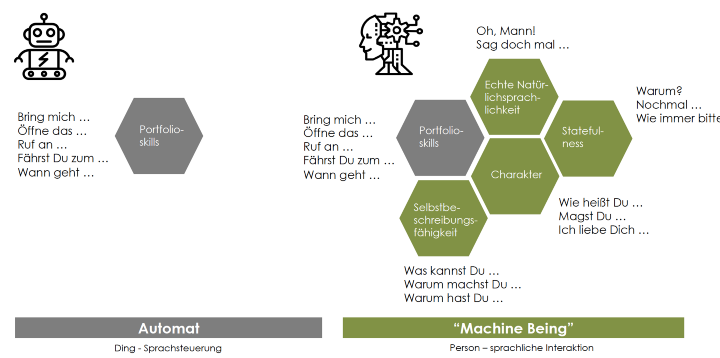

Erste kommerzielle Sprachanwendungen wurden, wie ein graphisches User-Interface konzipiert: Die Systeme haben genau die Tasks erfüllt, die im Portfolio hinterlegt waren. Inzwischen sind die Sprachassistenten viel breiter angelegt: Die Maschinen lassen sich allgemeiner ansprechen. Inzwischen kann Alexa mir antworten, wenn ich ihr sage, dass ich sie liebe. Sprachassistenten entwickeln sich also von Voice Automaten zu Machine Beings.

Warum modellieren wir eine Maschine zu einer menschenähnlichen Person?

Wenn eine Maschine natürliche Sprache versteht und sich jenseits ihrer Portfolio-Skills unterhalten kann, verringert sich die Unsicherheit in der Kommunikation: Für den Menschen ist die Maschine jetzt kein unbekanntes Ding mehr, sondern ein Exemplar einer vertrauten Kategorie: Ich kann mit ihr sprechen wie mit einem Menschen.

Xiaoce, ist ein Sprachsystem von Microsoft China, als Avatar hat das System den Charakter eines jungen Mädchens bekommen. Viele Leute quatschen stundenlang mit der Software. Sie hat mehr als 40 Millionen Nutzer. Dieses System beruht auf Large Language Models.

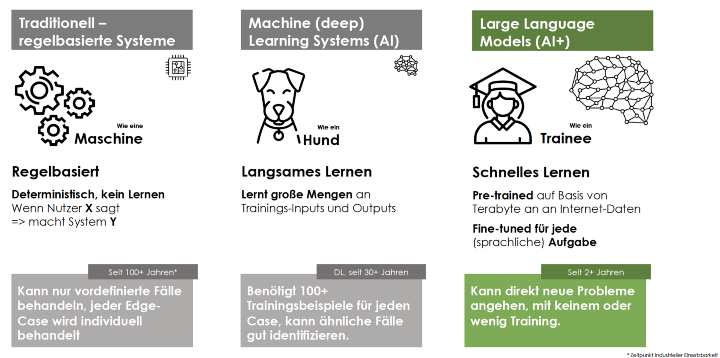

Was sind diese Large Language Models?

Bei Large Language Models (LLM) wird das System mit mehreren Terabytes an Internet-Texten vortrainiert. Auf dieser Basis ist das Modell in der Lage, natürlichsprachlich zu sprechen und Sach- und Logikfragen zu beantworten. Ich unterhalte mich mit jemandem, der die Wikipedia gelesen hat. Vollständig. Und in allen Sprachen. Mit einem spezifischen Training kann es dann noch für eine bestimmte Aufgabe tweaken.

Am besten funktionieren LLM auf Englisch. Das liegt daran, dass die LLMs mit Internetdaten gefüttert werden und das meiste Material im Netzt auf Englisch vorliegt.

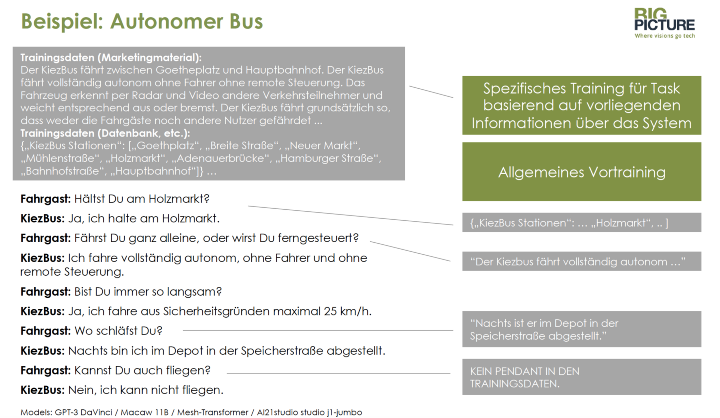

Hier habe ich ein spezifisches Training für einen autonomen Bus dargestellt.

Basierend auf dem Vortraining, speise ich spezifische Trainingsdaten in das System ein, zum Beispiel Marketing- und Kommunikationsmaterial sowie Datenbankinhalte über Haltestationen oder Verkehrszeiten. Auf Basis dessen kann der Bot eine Menge Fragen beantworten, die in diesem Material behandelt werden.

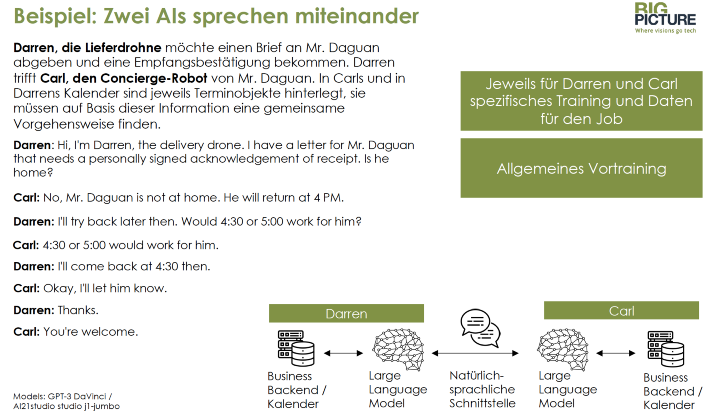

In meinem letzten Beispiel statten wir zwei autonome Systeme mit Sprachfähigkeiten aus und lassen sie aufeinander los:

Lieferdrohne „Darren“ möchte einen Brief mit Empfangsbestätigung abgeben, Concierge-Robot „Carl“ verwaltet den Terminkalender des Briefempfängers. Beide Maschinen müssen einen gemeinsamen Zeit-Slot auf Basis ihrer Terminkalendereinträge finden.

Die Verhandlungen sind nicht super schnell, aber die Maschinen sind in der Lage einen Terminslot zu vereinbaren. Zwei kluge Menschen hätten diesen Task vielleicht in der Hälfte der Zeit hinbekommen. Aber für zwei Maschinen ohne definierte Schnittstelle ist das Ergebnis schon bemerkenswert.

Was daraus folgt?

Wenn wir die Welt in Zukunft mehr mit autonomen Systemen in unseren öffentlichen und privaten Sphären ausstatten, dann sorgen wir dafür, dass die neuen Entitäten unseren Alltag bereichern. Als verständliche, angenehme, spannende Gesprächspartner.

Eine ausführliche Version dieses Artikels habe ich auf MEDIUM veröffentlicht.

Vielen Dank an die CURPAS-Veranstalter, Prof. Dr. Uwe Meinberg und Dr. Christina Eisenberg für den wunderbaren Event und die Einladung!

Ganz lieben Dank auch an Max Heintze, Kirsten Küpper und Hoa Le-van Lessen für Inspirationen und Support bei der Präsentation und Text.