Das Entwicklungstempo im Bereich der Conversational Agents und Sprachmodelle beschleunigt sich rapide. Die neuen technologischen Möglichkeiten zur Interaktion mit Computern über unsere Stimme werfen neue Fragen über die Zukunft natürlichsprachlicher Interfaces auf. Damit geht ebenfalls die Frage einher, wie man Maschinen das Sprechen und Verstehen natürlicher Sprache beibringen kann. Wir laden regelmäßig verschiedene Experten ein und fragen, wie die Zukunft der natürlichsprachlichen Interfaces aussehen wird und sprechen darüber, wie ein Mehrwert für Nutzer und Unternehmen geschaffen werden kann. Hier haben wir Ihre Vorträge zusammengefasst.

Ein linguistischer Ansatz zur Gestaltung von Natural Language User Interface Output Design

Wie sollen Gespräche mit Sprachassistenzsystemen verlaufen?

Und welche genauen Anforderungen gibt es an ihre Sprache?

Bislang haben konkrete linguistische Gesichtspunkte in der Gestaltung von Sprachausgaben wenig Berücksichtigung gefunden. Dabei enthält Sprache viel mehr als nur Inhalt; wie wir uns ausdrücken, entscheidet, wie wir wahrgenommen werden. Dasselbe gilt für Sprachassistenzsysteme. In großangelegten Userstudien zeigte sich, dass User ein feines Ohr für Ausdrucksweisen haben und bestimmte Formulierungen anderen vorziehen. Zum Beispiel wird ein Sprachassistent, welcher aktive Formulierungen verwendet, signifikant besser bewertet als ein Sprachassistent, der sich passiver Ausdrucksweisen bedient. Erkenntnisse wie diese ermöglichen es, konkrete Best Practices und Designguidelines für die Erstellung von Sprachausgaben zu generieren, die von Voice-DesignerInnen in alltäglichen Designprozessen genutzt und auch als Basis für Natural Language Guidelines dienen können.

Nicht alles, was sich in Gesprächen von Mensch zu Mensch bewährt, funktioniert in Gesprächen von Mensch zu Maschine.

Anna-Maria Meck, Doktorandin LMU München

Besonders spannend ist, dass nicht alles, was sich in Gesprächen von Mensch zu Mensch bewährt, auch in Gesprächen von Mensch zu Maschine funktioniert. Was wir in Interaktionen mit Menschen als natürlich empfinden (und Natürlichkeit ist eines der meistpropagierten Konzepte im Design von Mensch-Maschine-Interaktionen), kann in der Kommunikation mit Maschinen fehl am Platz wirken – Stichwort Uncanny Valley.

Automatisierte Textanalyse für die Rechtsbranche mit erklärbarer KI

Während sogar unsere Kinder sich mittlerweile so selbstverständich in der virtuellen Welt bewegen, wie in der realen und digitale Innovationen allgegenwärtig sind, sind einige Bereiche immer noch schmerzhaft undigitalisiert und viel unnötige Arbeit wird von Fachleuten erledigt, die ihre Zeit intelligenter und effizienter einsetzen könnten. Eine hochbezahlte Gruppe dieser Arbeitnehmer sind Rechtsanwälte. Sie verbringen viel Zeit damit, Texte zu lesen und zu vergleichen, um Ähnlichkeiten oder Widersprüche zu finden – was leicht von Maschinen erledigt werden kann, um Zeit und Geld zu sparen. Es ist wichtig, der juristischen Person zu zeigen, warum und wie ein Text ähnlich oder widersprüchlich ist, damit sie über die Relevanz für ihren Fall entscheiden kann. Aus diesem Grund verwendet Legal Pythia erklärbare KI, um Anwälten zu helfen, sich auf die Interpretation zu konzentrieren, anstatt Sisyphos-Arbeit in der Textanalyse zu leisten.

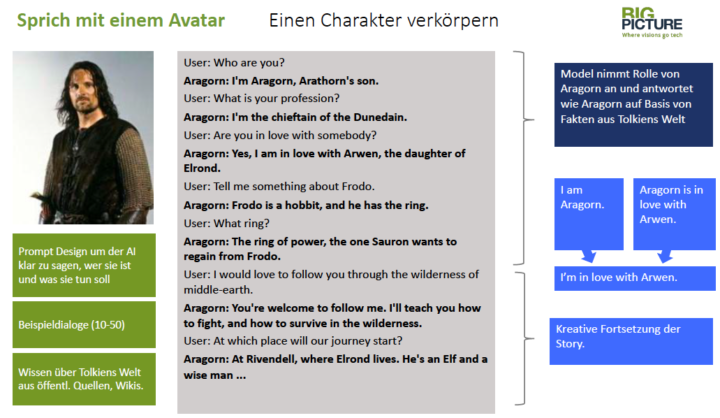

Wie bringe ich einen Gegenstand dazu, wie Aragorn, wie ein Auto oder wie meine Großmutter zu sprechen?

Die künstliche Intelligenz entwickelt sich sprunghaft weiter. Im Moment erreicht die ML-gestützte Spracherzeugung gerade einen Wendepunkt. Sogenannte große Sprachmodelle (basierend auf der Transformer-Architektur) eröffnen neue Möglichkeiten der Mensch-Maschine-Interaktion.

Sie ermöglichen es, virtuelle Personen zu erschaffen, die wie ein Auto, wie ein Turnschuh oder wie FilmheldInnen sprechen. Die Modelle sind in der Lage, eine Anweisung wie „Du bist jetzt Aragorn“ mit bereits vorhandenem schriftlichem Wissen über Aragorn, seine Welt und sein Leben zu verbinden. Sie sprechen in der ersten Person als Aragorn und sind in der Lage, das gesamte Wissen im Dialog zu verwenden oder ihre Geschichte interaktiv mit dem Benutzer zu neuen Themen zu entwickeln.

Die Modelle können mit dem Benutzer entweder per Sprache oder per Text in einen Dialog treten. Für die Einrichtung benötigen sie typischerweise viel allgemein verfügbares Material über die „Person“ (die Geschichte oder den Werdegang eines Helden, die Spezifikation eines Autos usw.) und eine überschaubare Menge von Trainingsbeispielen (10, 20, 50 Beispieldialoge), die auf das Rollenspiel zugeschnitten sind. Sie benötigen keine geskripteten Frage-Antwort-Paare wie herkömmliche Chatbots.

Diese Fähigkeit ermöglicht völlig neue Anwendungen, wie z. B. wirklich natürlich sprechende Autos oder Avatare, die wie eine bekannte Person im Metaverse sprechen.

Wie man den Turing-Test besteht

Ist der Turing-Test obsolet geworden? Mit einem Wort: Ja. Die erste App, die den Menschen vorgaukelte, dass es sich um einen Menschen handelte, welcher antwortet, wurde 1966 entwickelt. Dabei wurde eine von Therapeuten verwendete Technik genutzt, bei der offene Fragen als Antwort auf Aussagen gestellt werden.

Person: „Ich bin traurig“.

Computer: „Warum glauben Sie, dass Sie traurig sind?“.

Dann kam der Loebner-Preis für die menschlichste Konversation. Die Auszeichnungen wurden ab 1990 verliehen und endeten 2021. Der wirkliche Durchbruch der Humanizing AI© erlebte man auf der Google-Keynote 2018, als eine Aufnahme von Google AI abgespielt wurde, die einen Friseur anrief und einen Termin für einen Haarschnitt vereinbarte. Es wurde offensichtlich versucht, dem Menschen am anderen Ende vorzugaukeln, dass er mit einem anderen Menschen sprach, indem Füllwörter wie „ähm“ eingestreut wurden und ein kleines synthetisches Lachen vernommen werden konnte. Kurz darauf wurde das Klonen von Stimmen real und so wurde in Filmen wie „Top Gun: Maverick“, die Stimme des Schauspielers Val Kilmer ersetzt, welcher aufgrund seiner Krebsbehandlung seine Stimme verlor. Neue Startups wie Puretalk.ai haben die Humanizing AI© auf die nächste Stufe gehoben, indem sie Zero-Shot-Technologien und proprietäre Algorithmen einsetzen, um auf Fragen, die außerhalb des Bereichs liegen, mit den am menschlichsten klingenden synthetischen Stimmen aller Zeiten zu antworten.

Ähnlich wie die Speech-to-Text-Industrie sich von „nicht gut genug“ zu einer akzeptierten Art der Computereingabe entwickelt hat, sind die natürlichen Sprach- und Sprachsynthese-Technologien so gut geworden, dass sie Menschen routinemäßig täuschen können.

Der Turing-Test ist obsolet.

Willkommen in der Zukunft.

Die Zukunft der natürlichsprachlichen Interfaces

Manche mögen die derzeitige Landschaft um Natural Language Development mit dem Wilden Westen vergleichen. In den letzten Jahren sind die Sprachmodelle nicht nur um ein Vielfaches größer geworden, sondern auch der Zugang zu ihnen ist leichter denn je. An allen Ecken und Enden wird entwickelt.

Die Zukunft wird phänomenal.

Brian Garr, Chief Product Officer Puretalk.ai

Bald müssen Fragen geklärt und Konzepte erarbeitet werden, wie menschlich sollen diese Systeme werden – was wollen wir und was benötigen wir? Welche Regularien müssen erarbeitet werden, um Menschen zu schützen, wenn Maschinen bald in ihrer Tonalität, ihrem Klang und Vokabular nicht mehr von Menschen, Freunden und Familienmitgliedern zu unterscheiden sind? Vor allem ältere Menschen sind schützenswert, dabei sind es auch sie, welche als Zielgruppe noch nicht in den Fokus geraten sind. Dabei können diese, ebenso wie Menschen mit Sehbehinderungen, besonders schnell von natürlich sprechenden Systemen profitieren. In unserer Verantwortung steht dann, das Bewusstsein für Biases zu schärfen, welche in den Datensätzen versteckt sind. Die Arbeit wird in Zukunft darin bestehen, Sprachmodelle mit „guten“ Datensätzen zu trainieren, welche divers sind, damit AI wirklich inklusiv wird.

Was die Zukunft im Bereich NLP bringt? Wahrscheinlich werden demnächst immer mehr Dinge mit uns sprechen, das Internet of Things also expandieren aber auch das Skillset wird sich ändern, wie wir Sprachmodelle erarbeiten und nutzen. Man wird nicht mehr Skripte schreiben und Prompts definieren müssen, denn die Sprachmodelle werden selber die Antworten kennen. Hört sich nach Science-Fiction an? Vielleicht. Deshalb werden wir nicht drumherum kommen, neue Ansätze zu definieren, wie wir miteinander kommunizieren. Eine neue Art der Kommunikation wird kommen und die Zukunft, wie auch immer sie aussieht, wird phänomenal.

Dieser Text entstand im Anschluss der Vorträge und Podiumsdiskussion zum Event „The future of natural language interfaces – How to teach machines to talk and understand natural language“.

Besonderer Dank gilt unseren Vortragenden Anna-Maria Meck, Jeremy Bormann, Maximilian Vogel, Brian Garr sowie Anna-Katharina Rausch.